J'ai testé un chatbot "psy" de soutien pour salariés : il faut qu'on parle

- contact083742

- il y a 4 heures

- 4 min de lecture

J’ai testé un chatbot présenté comme un assistant psychologique pour les salariées et les salariés, réellement utilisé ici ou là comme une démarche de prévention des RPS. Je le raconte dans l'épisode 23 du podcast :

Cette note reprend quelques éléments évoqués dans cet épisode, pour les plus pressés.

En quête de ressources

J’ai proposé au chatbot trois situations très ordinaires : une surcharge de travail, un harcèlement hiérarchique et une exclusion par les collègues. Très vite, une logique stable apparaît : l’outil cherche une ressource : faire une liste de tâches, parler à quelqu’un dans l'entreprise, appeler une amie ou un ami, pratiquer un loisir, se concentrer sur du positif, etc.

La situation change, mais la réponse reste la même, traduisant une psychologie qui ne regarde pas ce qui se passe dans le travail, mais ce que la personne pourrait mobiliser pour “aller un peu mieux”, sans que rien ne change autour d’elle. C’est une manière de déplacer la situation vers l’individu (et peut-être de l’y enfermer).

J'ai eu envie d'en faire un pastiche, avec ce petit code qui fait, finalement, pas beaucoup plus mal que le chatbot que j'ai essayé (cliquez sur l'image pour le tester vous-même) :

Le grand absent

Mais ce qui est le plus frappant, c’est ce que le chatbot ne demande pas : pas une seule fois il ne pose la question qui, en psychologie du travail, organise toute compréhension d’une situation professionnelle : quel est votre métier ?

Cette question manque, et tout s’effondre autour. Parce qu’on ne vit pas une surcharge, un harcèlement ou un rejet de la même manière quand on est enseignante, soignante, éducatrice spécialisée, technicienne, ouvrière à la chaîne, professionnelle de l’aide ou cadre administrative. Le métier structure ce qu’on essaie de tenir, ce qu’on juge important, et ce qu’on ne peut pas abandonner sans (se) blesser.

Le chatbot m'a par exemple proposé, à plusieurs reprise, de “prendre du recul”, de “faire un pas de côté”, de “me retirer un peu”. Mais un retrait n’a rien d’universel. Pour une infirmière, se retirer signifie laisser des patientes et des patients trop nombreux pour l’équipe. Pour une travailleuse sociale, cela peut vouloir dire interrompre un lien fragile avec une personne qu’elle accompagne. Pour un métier technique, ce peut être accepter de provoquer des défaillances futures, etc.

Dans ces situations, se retirer n’est pas un geste neutre : c’est parfois trahir ce qu’on essaie de tenir dans son métier.

Six problèmes posés par les chatbots IA de "psy"

À la fin du test, une évidence s’impose. Ce que j’ai exploré n’est pas un gadget un peu maladroit, mais le symptôme d’un mouvement plus large qui mérite d’être interrogé. Voici les six difficultés principales, telles qu’elles apparaissent aujourd’hui.

1. Ces IA ne pensent pas : elles prédisent

Elles produisent le mot probable, pas le mot juste. Elles n’ont ni perception, ni jugement, ni compréhension. Elles imitent la conversation sans jamais accéder à ce que vivent les personnes, et ne peuvent pas entendre le travail... seulement générer du discours.

2. Les entreprises n’ont aucun contrôle sur leur apprentissage

Les modèles sont entraînés ailleurs, sans aucune maîtrise de l'entreprise qui veut se doter de l'outil, avec d’autres normes donc d’autres biais (souvent anglo-saxons). Rien ne garantit qu’ils soient adaptés aux métiers, aux règles implicites ou aux conflits réels de l'organisation. Confier une fonction d’écoute à un artefact dont on ne maîtrise ni la culture ni les références peut devenir dangereux, surtout en période de crise, de réorganisation ou de plan social.

Cela dit, il vaut mieux que les chatbots se limitent à chercher des ressources : s’ils s’aventuraient à analyser les métiers avec des concepts douteux (soft skills, DISC, leadership “authentique”), les dégâts seraient autrement plus importants.

3. Ce n’est pas de la prévention au sens du Code du travail

La prévention consiste à agir sur les causes, pas à apaiser les effets. Une IA n’agit sur rien. Elle ne modifie pas la charge, ne régule pas les collectifs, ne lit pas les signaux faibles, ne transforme pas l’organisation. Elle contourne les causes structurelles et déplace tout vers l’individu. C’est un amortisseur émotionnel, pas un outil de prévention.

4. Le risque d’aliénation est réel

Remplacer un espace humain de parole par un robot revient à déposséder les personnes de leur pouvoir d’analyse et d’action. On installe une croyance : “si l’outil répond bien, c’est qu’il comprend”. En réalité, il ne comprend rien, il mime. Et ce glissement entretient une confusion dangereuse entre soulagement momentané et compréhension du travail.

5. Le risque réglementaire est loin d’être anecdotique

Données sensibles, données de santé, RGPD, IA Act… Le cadre juridique n’est ni clair ni stabilisé, surtout quand il s’agit d’un outil qui collecte (ou pourrait collecter) des informations intimes liées à la santé mentale et aux conditions de travail. Tout cela est potentiellement explosif pour les entreprises comme pour les personnes.

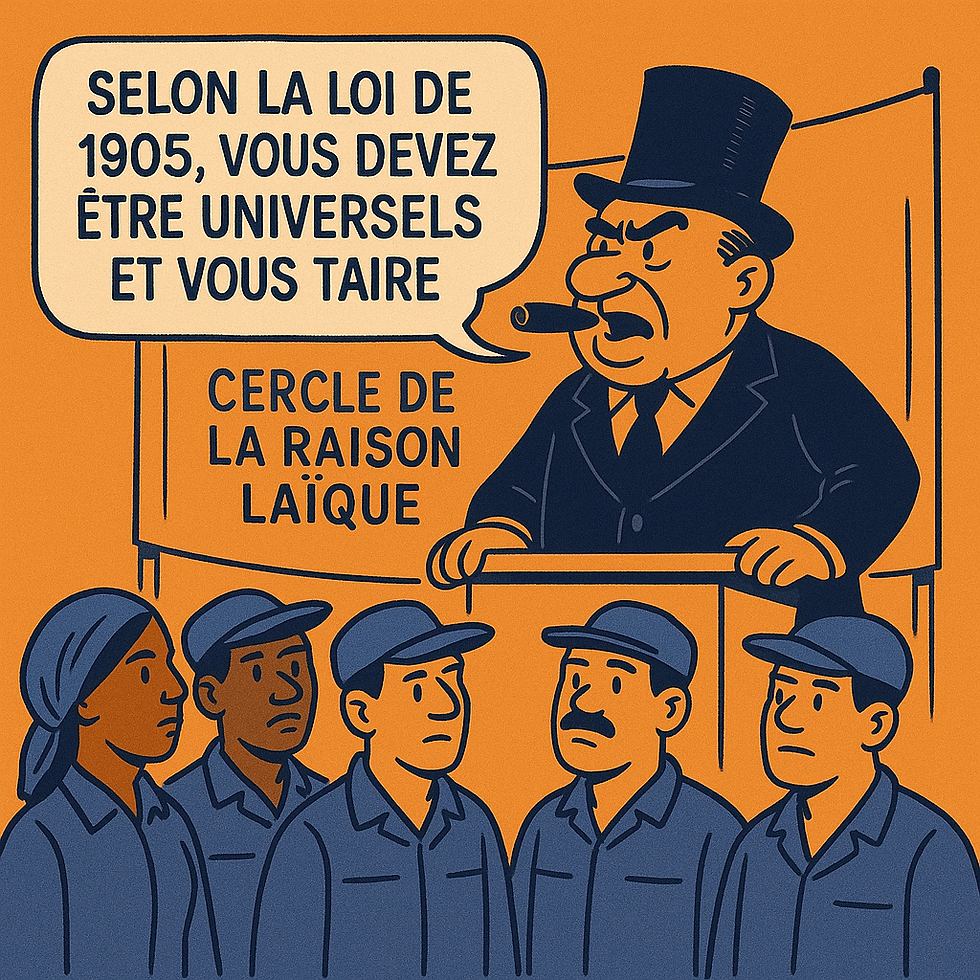

6. Enfin, l’effet symbolique est énorme

Dire aux salariées et aux salariés : “Voici un chatbot pour parler de ce que vous vivez”, c’est se priver du travail sur le travail. C’est installer un écran entre les personnes et l’organisation. Le message implicite est limpide : “on va gérer vos émotions, pas votre travail”.

Et ce signal-là, à lui seul, devrait suffire à nous alerter.